|

|  |

Durch die jüngst erreichten Fortschritte in der beobachtenden

Kosmologie ist es gelungen, ein Standardmodell für den

Materieinhalt des Universums und seine Anfangsbedingungen für die

Strukturentstehung 300000 Jahre nach dem Urknall zu entwickeln. Der

größte Teil der Masse im Universum (~85%) besteht aus

dunkler Materie, einem bisher noch nicht identifizierten, schwach

wechelwirkenden Elementarteilchen. In der inflationären Phase des

Universums wurden kleine Störungen in der ansonsten

gleichförmigen Verteilung dieser Massenkomponente erzeugt, welche

dann durch gravitative Instabilität verstaerkt werden,

während sich das Universum weiter ausdehnt. Schließlich

kollabieren die Störungen und bilden die Galaxien, die wir heute

sehen. Dieser hochgradig nichtlineare und dreidimensionale

Prozeß kann durch ein stoßfreies N-Teilchen-System

modelliert werden, welches sich unter Eigengravitation

entwickelt. Dabei ist es allerdings von entscheidender Bedeutung,

möglichst viele Teilchen zu benutzen, um ein möglichst

genaues Bild der Dynamik im Universum zu erhalten.

Wissenschaftlern am Max-Planck-Institut für Astrophysik, zusammen

mit Kollegen des internationalen Virgo Konsortiums, ist es nun

gelungen, in einer neuen Simulation dieser Art die benutzte

Teilchenzahl auf mehr als 10 Milliarden zu steigern. Dies liegt etwa

eine Größenordung über der Teilchenzahl, die bisher

von den größten Simulationen in diesem Gebiet erreicht

worden ist, und übertrifft die langfristige Wachstumsrate der

Größe von kosmologischen Simulationen deutlich. Aus diesem

Grund wird das Projekt von dem Wissenschaftlerteam auch

"Millennium-Simulation" genannt. Der hier erreichte Fortschritt wurde

durch wichtige algorithmische Verbesserungen im Berechnungsverfahren

erlaubt, sowie durch den erreichten hohen Grad der Parallelisierung,

welcher es möglich machte, die Simulation auf 512 Prozessoren des

IBM p690 Supercomputers des Rechenzentrums der Max-Planck-Gesellschaft

(RZG) durchzuführen. Dennoch stellte die Simulation erhebliche

rechnerische Anforderungen. So mußte etwa annähernd der

gesamte physikalische Hauptspeicher von 1 TB auf dem parallelen

Computer benutzt werden, und auch die Analyse der etwa 20 TB an

produzierten Daten erforderte innovative Methoden.

Das Simulationsvolumen ist ein periodischer Würfel von 500 Mpc/h

Kantenlänge, wodurch sich eine Teilchenmasse von 8.6 x 108/h

Sonnenmassen ergibt. Dies ist genug, um Zwerggalaxien mit einigen

hundert Teilchen, Galaxien wie die Milchstraße mit einigen

tausend, und die schwersten Galaxienhaufen mit einigen Millionen

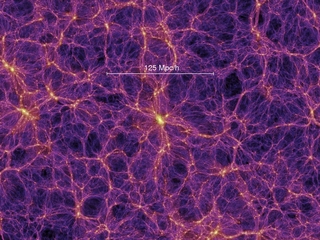

Teilchen aufzulösen. Das obere Bild in Abbildung 1 zeigt eine

Visualisierung der Großraumstruktur in der dunklen Materie zur

heutigen Zeit. Die Simulation zeigt eine vielfältige Population

aus Halos aller Größen, die mit Filamenten aus dunkler

Materie verbunden sind, so dass sich ingesamt eine komplexe Struktur

ergibt, die als "Cosmic Web" bezeichnet wird. Die räumliche

Auflösung der Simulation beträgt 5 kpc/h pro Raumdimension

und ist überall in dem simulierten Volumen verfügbar. Damit

ergibt sich ein großer dynamischer Bereich von 105 in 3D,

welcher extrem genaue statistische Messungen der Struktur der dunklen

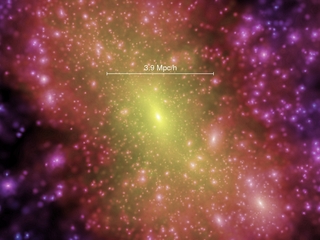

Materie im Universum erlaubt. Insbesondere kann auch die Substruktur

in individuellen Halos aufgelöst werden, wie im unteren Bild der

Abbildung 1 zu sehen ist, in welchem eine Vergrößerung von

einem der massereichen Galaxienhaufen in der Simulation gezeigt ist.

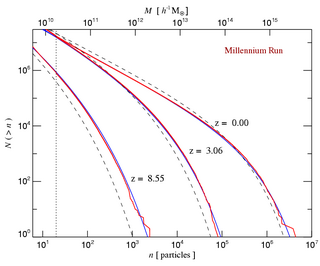

Als ein Beispiel für die bemerkenswerte Genauigkeit, mit der sich

grundlegende kosmologische Größen mit der Simulation

bestimmen lassen, zeigen wir in Abbildung 2 die nichtlineare

Halo-Massenfunktion zu verschiedenen Zeitpunkten.

Eine wichige Eigenschaft der Millennium-Simulation ist, dass sie eine

nahezu komplette Bestandsaufnahme aller leuchtkräftiger Galaxien

liefert, die heller als etwa ein Zehntel der charakteristischen

Galaxienleuchtkraft sind. Dieser Aspekt ist besonders wichtig, um eine

neue Generation theoretisch vorausgesagter Galaxienkataloge zu

erzeugen, welche zum ersten Mal einen "ebenbürtigen", direkten

Vergleich mit Beobachtungsdatensätzen erlaubt. Dies wird

möglich, da die Simulation eine ausreichende Massenauflösung

aufweist, um eine representative Verteilung aller Galaxiengrössen

zu erhalten, obwohl gleichzeitig ein Volumen vergleichbar mit der

Größe der kürzlich verfügbar gewordenen

Rotverschiebungskataloge großer Beobachtungsprogramme abgedeckt

wird. Die Galaxien aus der Millennium-Simulation werden in der

Datenbank eines "Theoretischen Virtuellen Observatiums" gespeichert

werden, welches dann ähnliche Suchanfragen erlauben wird, wie sie

bereits auf Beobachtungsdatenbanken angewandt werden. Das große

Volumen der Millennium-Simulation ist auch besonders wichtig, um

seltene Objekte geringer Anzahldichte, wie etwa massereiche

Galaxienhaufen, oder die ersten Quasare bei hoher Rotverschiebung, zu

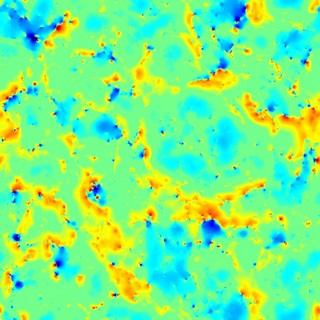

studieren. Gleichzeitig ermöglicht es der dynamische Bereich der

Simulation, genaue Voraussagen für starke und schwache

Gravitationslinseneffekte zu machen, wowie die Fluktuationen im

kosmichen Mikrowellenhintergrund zu studieren, die durch die

nichtlineare Entwicklung des Gravitationspotentials aufgeprägt

werden (Abbildung 3). Vor dem Hintergrund des beginnenden Zeitalters

der "precision cosmology", erweisen sich große

Computersimulationen wie das Millennium-Projekt als immer wichtiger,

um die volle Komplexität der kosmischen Strukturen zu erfassen

und empfindliche Tests des gegenwärtigen theoretischen

Verständnisses zu entwickeln.

Volker Springel

Weitere Informationen:

Virgo-Konsortium Virgo-Konsortium

Virgo-Seite am MPI für Astrophysik Virgo-Seite am MPI für Astrophysik

A. Jenkins, C.S. Frenk, S.D.M. White, et al., "The mass function of dark

matter halos", Mon. Not. R. Astron. Soc., 321, 372 (2001)

V. Springel, N. Yoshida, S.D.M. White, "GADGET: a code for collisionless

and gasdynamical cosmological simulations", New Astronomy, 6, 79 (2001)

V. Springel, S.D.M. White, G. Tormen, G. Kauffmann, "Populating a cluster

of galaxies: Results at z=0", Mon. Not. R. Astron. Soc., 328, 726 (2001)

|